人工智能产业总带着些许魔法气质,人们最异想天开的设想在这总能得到实现,机器人战胜了围棋冠军,淘宝算法能猜中你的消费喜好,火遍全球的GPT-3更是看起来无所不能——可以生成足以以假乱真的新闻文章,仅根据语言描述就能创作网页和手机UI,甚至能自动生成科学问题并回答,GPT-3真的这么“神奇”吗?

在了解 GPT-3 的神奇之处前,我们需要先对 GPT-3 有个概括性的认识。GPT-3 是人工智能科研公司 OpenAI 开发的自然语言模型,即generative pre-trained transformer的缩写,翻译过来叫生成型预训练变换器。变换的意思,就是你用人类语言和他对话,他转换成机器听得懂的机器语言做处理并且完成任务,处理完再把任务结果转换成人类语言交给你。偷偷说一句,变形金刚英文就是transformer,这是模型的名字是不是很霸气呢。

除了名字,GPT-3 的业务能力同样“霸气”,能完成超过50项的自然语言处理任务,并且完成水平创下历代模型新高度,那GPT-3到底有多强呢?

一位名叫Liam Porr的美国小哥,来自加州大学伯克利分校计算机科学系,他参考最热的网文风格,用GPT-3生成了几篇文章,没想到竟然打败了一票人类作者,登上了新闻平台技术板块热榜第一!

有趣的是,一大部分人压根没察觉到文章不是人类写的。接下来,帖子在短短几个小时内就迅速传播开来,访问量超过了26,000,竟然登上了YC新闻平台Hacker News热门榜第一名,甚至有读者读后留言称,“好文!和Ethan Hawke在Ted的演讲一样深刻”。

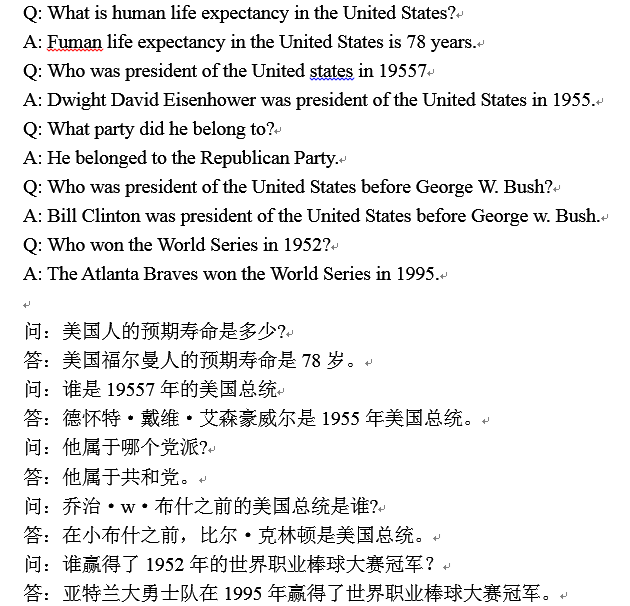

我们再来看看GPT3在问答任务上的表现。

问:美国人的预期寿命是多少,答:78岁

之前的语言模型在这种常识问答中,通常会宕机,但是GPT-3却表现很好,好似把维基百科的知识都吃透了,能快速了解你的问答意图。

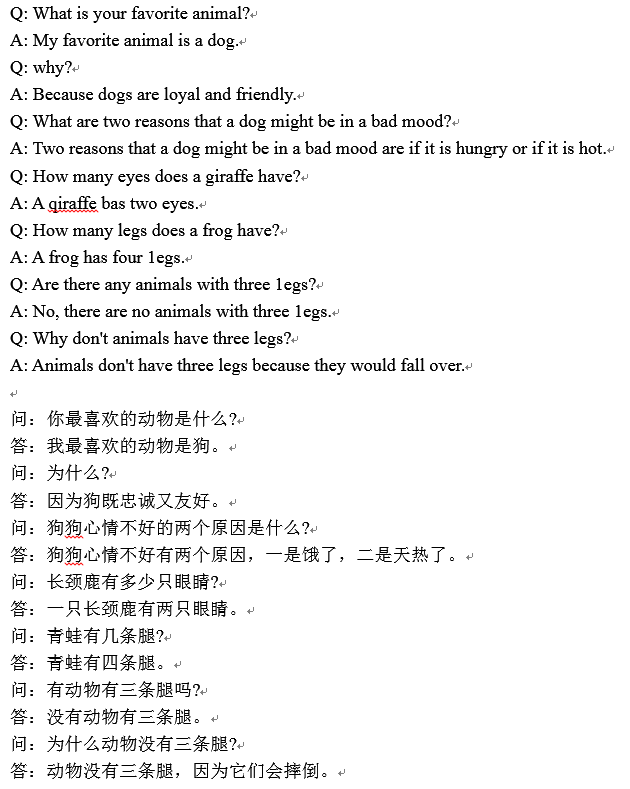

多轮对话也是手到擒来,放到十年前,上面的对话会不会让你以为是个真人?

看到这样的结果,可能会有些疑问,GPT-3怎么知道长颈鹿有两只眼睛?我们也不确定,只能推测,在它的训练数据中,一定有一些网页,讨论了长颈鹿有多少只眼睛。

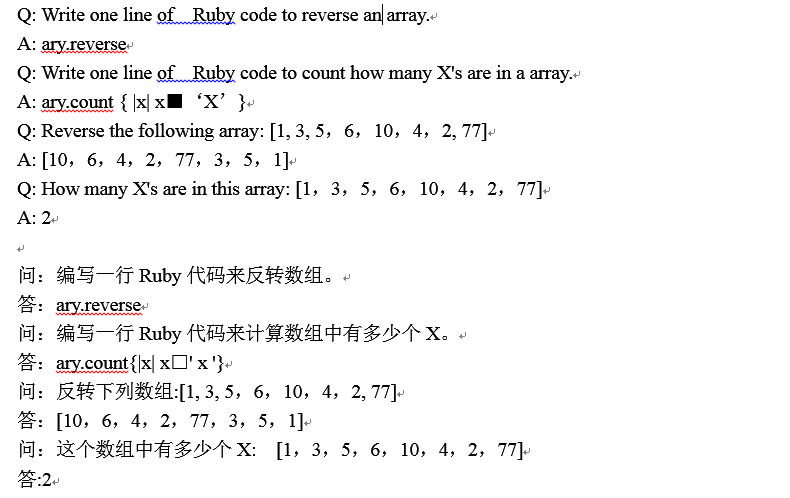

更有趣的是,GPT-3通过编写代码可以解决很多编程型的问题,你如果用代码作为提示,它就会试着写代码来回答。

可以看到,GPT-3模型的行为会随着不同的提示而发生巨大的变化。所以它是很容易迁移的,你只需要少量的提示,就能改变 GPT-3的在具体的任务上的性能。

这也是GPT-3 的又一大里程碑式的突破——不再需要对特定任务进行微调,具有很强的业务迁移能力。普遍来说,在自然语言领域中,通常采用的做法是:先在大量的语料上预训练语言模型,然后再将预训练好的模型迁移到具体的下游自然语言任务,从而提高模型的应用能力。也就是先完成基础训练,再微调以执行特定任务,包括 GPT-2也需要进行微调。但是 GPT-3 不再需要微调,它只需要一些所需输出类型的样本(称为 " 少量学习 "),就可直接迁移到各种 NLP 任务中,用户只需要输入正确的提示就可以指挥它,因此具有很强的业务迁移能力。

即使是变形金刚也有弱点,GPT-3 的优势非常明显,弱点同样突出。

比如,GPT-3处理加法运算的表现并不是特别好。如果你让它做一位数、两位数的加法,正确率基本能达到百分之百,但如果你让它用5位数加5位数,它的正确率就会迅速下降。这一点很奇怪,因为如果一个小孩已经学会加法,一般不会再出现很大的错误,除非是粗心,但是计算机是不会粗心的。大概是由于其神经网络本身结构的缘故,没有一个神经网络能够基于训练数据而不是硬编码在大量数字上做加法和乘法等基本算术运算,所以复杂的数学运算任务会失败。对于一个程序来说,有些数学操作很简单,编写个递归就行了。但是,某些递归逻辑通常不能很好地映射到神经网络结构上,这就造成GPT-3不擅长做运算。

并且GPT-3在进行简单的推理方面也存在着明显的失误,这一原因可能是:它只是自动检索数据并输出,不是真正思考的结果。

例如:问:我的脚有多少只眼睛?

答:你的脚有两只眼睛。

问: 太阳有多少只眼睛?

答: 太阳只有一只眼睛。

问: 一片草有多少只眼睛?

答: 草有一只眼睛

这正好与上文相呼应,GPT-3 能正确回答“长颈鹿有2只眼睛”不是经过推理,而是因为在网页训练数据中包含这一问题,显然网页上没人会讨论“太阳/草有几只眼睛?”,所以当 GPT-3 被提问时,它没法将太阳与眼睛进行推理,得出正确的回答。可以说,GPT-3 只是大数据训练的结果,无法超越数据本身,也无法拥有推理的能力,所以,我们不如说它学会的是“统计层面的复制粘贴能力”。

即使是目前最先进的自然语言模型(GPT-3)也无法完成推理,但是在中国南面,一家名为智视科技的人工智能企业,自主研发的小智AI系统,具备推理能力!

推理即利用多个已知的知识进行组合,推理得到新的知识。那推理有多重要呢?我们可以从应用层面得到解答。

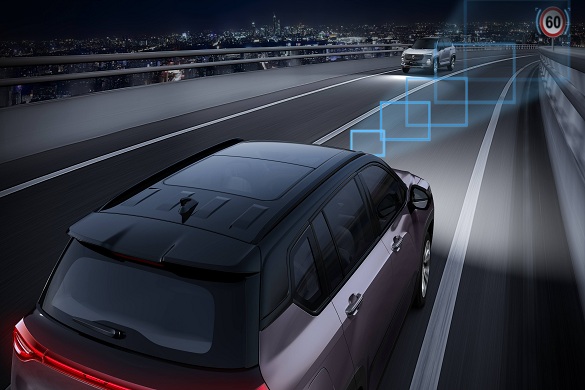

目前来说,许多AI教育公司在建立题库时,发现题目每年都在更新,题库不能收录所有题目,这就造成用户在搜索某些题目时,不能搜到相关解答,降低用户体验满意度。而小智AI的推理能力可以利用已知知识,推理解答题库中没有收录的题目。不仅是教育领域,小智的推理能力使得系统可以针对不同应用需求进行灵活且快速地部署和弹性地拓展,以达到最佳的应用效能,从而助力自动驾驶、智能音箱、智慧制造等行业客户。

据海外数据统计,仅在2019年,和特斯拉汽车相关的严重交通事故就有46起,事故造成了50人死亡。总体来说,各品牌自动驾驶汽车造成交通伤亡事件层出不穷,其中一种可能性是传感器检测到行人后,车辆并不知道应该做什么。而小智AI的推理能力使得自动驾驶车辆可以针对道路上可能会出现的大量不可预知的事件做出即时推理(例如:将当前车速与障碍物距离进行推理)并决策、输出正确指令(例如:减速停车),进一步保证无人驾驶的行车安全。

同时,智能音箱领域也离不开推理。智能音响因其极可能成为未来家庭的控制中心,而成为科技大佬们的必争之地。经过数年的发展,大佬们向智能音箱灌输大量的数据使其可以回答用户的大多数提问,但是使用满意度并不高,大部分用户们反馈“只能一问一答,一点都没有真人对话的感觉”,仍尚未没有解决“聊天”这一用户痛点。打个比方,今天上班很困,想和小爱同学聊天。于是小编说“我好困”,小爱同学会说“困了就快去休息吧,我们梦里接着聊”,小编继续说“可是我在上班”,小爱同学就不知道该如何回应小编。原因在于,基于深度学习的自然语言理解,仅能提取概念实体,并不能进行逻辑推理,无法理解用户意图,也就无法顺利聊天。当小智AI的推理能力加载到智能音箱中,智能音箱就能在对话过程中不断根据用户的前后语句推理用户意图,并决策下一步应该采取的最佳回应,让智能音箱真正做到“百分百懂用户”,能像正常人那般聊天。

小智的推理能力在工业上也有不小的应用。传统AI(不可推理)在工业中只能依赖机械臂进行简单的流水线操作,富士康的“机器换人”计划就是朝这个方向前进。但是该计划目前进展并不乐观,机器换人在标准化产品的生产中是可行的,比如:口罩、锅碗瓢盆等产品样式与大小可维持十几年不发生变化,但是并不适用于创新程度高的产品,例如智能手机,这偏偏是富士康的主体业务。智能手机行业更新极为迅速,从零件到工艺都快速迭代,但是传统AI生产线欠缺灵活性,没法根据手机的新标准进行快速部署,跟不上智能手机的发展进化速度。而拥有推理能力的小智AI可以成为工厂的“大脑”,通过AI对原料、产出、生产时间、废料排放等数据进行智能调配,将粗放型经营变为智能型经营,降低企业成本。例如:河南一家煤炭焦化企业,利用AI算法来进行焦炭质量预测和配煤比例优化,从而实现再不降低产品质量的前提下,达到解决成本每吨20-70元,一年可以节省数千万元成本。

总之,小智的推理能力的应用范畴覆盖全领域、全行业,推理让AI变得更灵活、更具思考性,从而高效赋能任意行业。

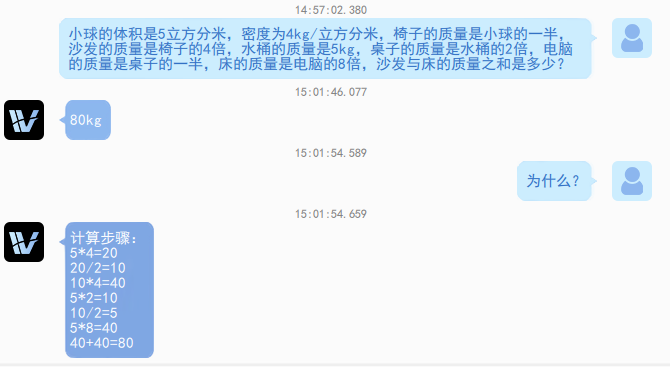

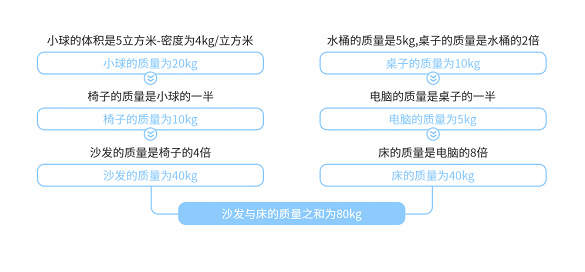

最后一部分是小智AI的技术展示。推理过程分为理解问题和分步骤推理。为了让读者更好的理解,这里以简单数学题为例。

首先是理解问题。就和人类解题一样,第一步是理解题干,利用自然语言技术将题目文字转换成机器语言,从而让系统“读懂”题目。

其次是分步骤推理,即根据题干,组合题目的各个已知条件进行逐一推理,直至解答。本题需要求解“沙发与床的质量之和”,但是题目中并没有明确提示沙发与床的质量分别是多少,这就需要进行推理,系统将分别推理出沙发和床的质量各是多少,再相加。首先是沙发,根据“沙发的质量是椅子的四倍、椅子的质量是小球的一半、小球的体积是5立方米,密度为4kg/立方米”,先计算出小球的质量,再根据小球的质量推理椅子的质量,根据椅子的质量再次推理才能得出沙发的质量,仅是沙发质量的推理过程就需要3个步骤。同理,系统将按照同一方法,推理床的质量,最后将沙发与床的质量相加,得出答案:80kg。

(灰框代表条件,蓝框代表推理过程)

可以看出,整个解题过程非常接近人类的推理方式,并且进行了多达7个步骤的连续推理, 系统能根据题目条件进行灵活推理和解答问题。同时,这一推理能力也是AI系统在商业落地中的关键能力。当小智AI拥有推理能力,就能根据工作场景中实际条件的变化,进行灵活的调整,一反传统AI的刻板属性,发挥AI的最大价值!